robots配置

什么是robots.txt?搜索引擎爬虫的 “访问规则指南”robots.txt是存于网站根目录的文本文件,核心作用是通过特定语法告知搜索引擎爬虫可访问或需忽略的页面/目录,帮助优化爬行效率、节省爬行预算。它并非安全工具,无法阻止恶意访问,配置时需注意语法规范与爬虫兼容性,避免泄露敏感信息。

一、robots.txt的核心定义:爬虫的“入门导航规则”

robots.txt是网站根目录下的纯文本文件,专门用于与搜索引擎爬虫(如Googlebot、百度蜘蛛)沟通。它通过明确的规则,告知爬虫网站中哪些页面、目录允许爬行,哪些需要回避,是指导爬虫高效工作的核心配置文件,也是技术SEO的基础环节。

二、robots.txt的4大核心基本语法

robots.txt通过简单固定的语法定义规则,核心指令包括:

1. User-agent:指定适用爬虫

用于明确规则针对的搜索引擎爬虫,是每条规则的开头。使用“*”表示规则适用于所有爬虫;也可指定具体爬虫名称(如Googlebot、Bingbot),仅对该爬虫生效。

2. Disallow:禁止访问指令

定义爬虫不允许访问的页面或目录,路径需从网站根目录开始写。例如“Disallow: /admin/”表示禁止爬虫访问/admin目录及其下所有内容;“Disallow: /”则表示禁止爬虫访问网站所有页面(极少使用)。

3. Allow:允许访问指令

用于覆盖父目录的Disallow规则,明确指定爬虫可访问的页面或目录。例如父目录“/data/”被Disallow,但“/data/public/”需允许访问,可通过“Allow: /data/public/”实现。

4. Sitemap:指定网站地图位置

用于告知爬虫网站地图(Sitemap)的URL地址,帮助爬虫快速找到网站地图,提升索引效率。语法格式为“Sitemap: 网站地图完整URL”,可在文件末尾添加。

三、robots.txt的3个实用配置示例

结合常见场景,以下示例可直接参考配置:

1. 禁止所有爬虫访问特定目录

需阻止所有爬虫访问后台管理目录(/admin/)和私人数据目录(/private/),配置如下:

User-agent: *Disallow: /admin/Disallow: /private/2. 允许特定爬虫访问指定目录

禁止所有爬虫访问/images/目录,但允许Googlebot访问,配置如下:

User-agent: *Disallow: /images/User-agent: GooglebotAllow: /images/3. 指定网站地图位置

在规则末尾添加网站地图地址,帮助爬虫快速识别,配置如下:

User-agent: *Disallow: /admin/Sitemap: https://example.com/sitemap.xml四、使用robots.txt的6大核心注意事项

配置robots.txt需规避常见误区,否则可能影响爬虫爬行与索引:

1. 并非安全防护工具

robots.txt仅为“君子协定”,仅对遵守规则的搜索引擎爬虫有效,无法阻止恶意爬虫、黑客或有意图的用户访问被Disallow的内容,不能用于隐藏敏感信息(如用户数据、隐私内容)。

2. 路径大小写敏感

大多数服务器(如Linux服务器)对URL路径的大小写敏感,例如“Disallow: /Admin/”与“Disallow: /admin/”是两条不同规则,需确保路径与网站实际目录大小写完全一致。

3. 规则匹配URL开头

Disallow规则采用“前缀匹配”,只要URL以规则中的路径开头即生效。例如“Disallow: /page”会禁止访问“/page1”“/page/abc”等所有以“/page”开头的URL,需精准设置路径。

4. 子目录默认继承父目录规则

若Disallow某个父目录,其下所有子目录会默认被禁止访问。例如“Disallow: /data/”会同时禁止“/data/abc/”“/data/def/”等所有子目录,无需单独配置。

5. 不同爬虫可能有差异

部分小众搜索引擎的爬虫可能对规则解释存在差异,核心规则(如User-agent、Disallow)需遵循通用标准,避免使用特殊语法,确保主流爬虫都能正确识别。

6. 需测试规则有效性

配置完成后,建议使用Google Search Console的“robots.txt测试工具”或百度搜索资源平台的相关工具,验证规则是否生效,检查是否存在误禁止核心页面的情况。

五、robots.txt的核心SEO价值

正确配置robots.txt的核心价值的是“优化爬行效率、节省爬行预算”:通过禁止爬虫访问无价值页面(如后台页面、重复内容页、测试页),让爬虫将有限的爬行资源集中在核心页面(如产品页、文章页),提升核心内容的索引速度与覆盖率,为SEO排名打下基础。

一个好网站不仅要满足用户需求还要符合SEO规则。2025年12月19日

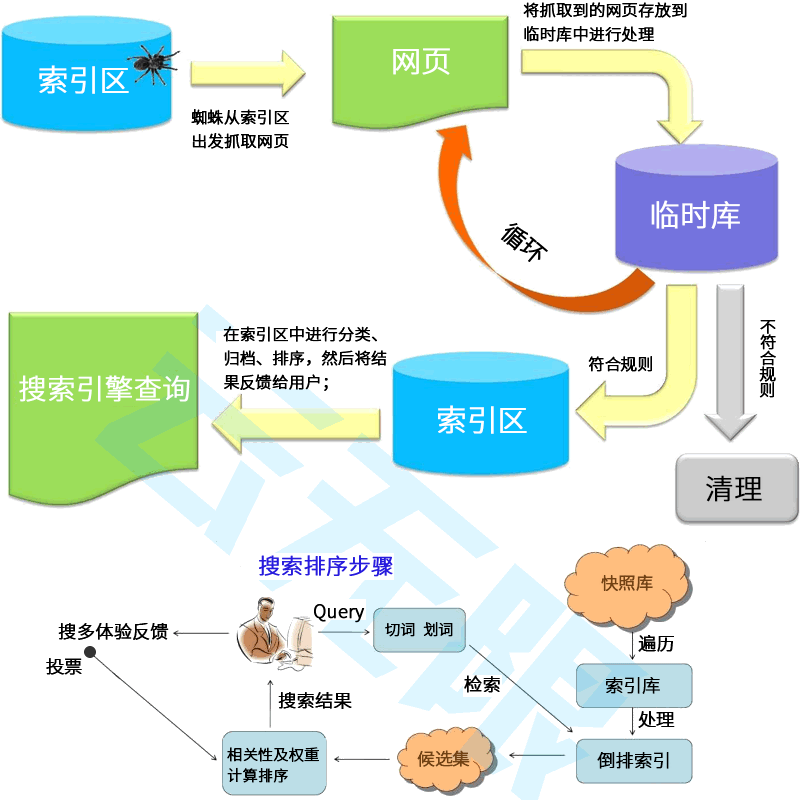

SEO的专业性远超你的想象!我们要做的是协助搜索引擎而不是欺骗它!它涉及到的不止是网站结构、内容质量、用户体验、外部链接这几个方面;还有算法的更替、蜘蛛的引导、快照的更新、参与排序的权重等。

一、让用户搜到你的网站是做SEO优化的目标,拥有精湛的SEO技术、丰富的经验技巧以及对SEO规则的深刻把握才有机会获得更多展现机会!

二、确保网站内容清晰、准确、易于理解,使用户能够轻松找到所需信息.使用简洁明了的标题和描述,帮助用户快速了解你的产品服务!

三、将企业的核心价值、差异化卖点、吸引眼球的宣传语等品牌词尽可能多的占位搜索前几页,增强用户印象,优化用户体验让访客信任你!

四、优化落地页引导用户咨询或预约留言,引用大型案例或权威报道彰显品牌实力,关注用户需求和反馈,不断优化产品服务让用户选择你!

SEO是企业有效的网络营销手段,可以帮助企业提升关键词排名,吸引更多用户,实现商业目标。SEO是一个长期且专业的技术,企业在进行SEO时,必须耐心优化,因为SEO涉及到的不止是网站结构、内容质量、用户体验、外部链接这几个方面;还有算法的更替、蜘蛛的引导、快照的更新、参与排序的权重等。

SEO网站推广

如果你的网站无法从搜索引擎获取流量和订单!说明你从一开始就没有建立正确的SEO策略。根据《百度搜索引擎优化指南2.0》+《网页内容质量白皮书》对网站进行规范化调整,提升百度蜘蛛的抓取效率,收录效率,排名展现效率和有效点击的效率。-

整站AI优化

1、不限关键词数量,不限关键词指数,添加词更灵活.

2、更懂用户搜索习惯、更懂SEO规则、更懂运营.

3、专业团队实施,量化交付、效果持续且有保障. -

关键词排名优化

1、让网站内部标签及HTML代码等更符合SEO规则.

2、指定关键词,不限关键词指数,不上首页不收费.

3、提升搜索蜘蛛抓取率,收录率,排名展现和访问率. -

外贸SEO优化

1、竞争对手分析,了解同行营销策略和行业趋势.

2、关键词保证到谷歌首页带来高价值流量及询盘.

3、涵盖谷歌、必应、雅虎各大搜索引擎友好抓取.

百度SEO排名

让用户搜到你、信任你、选择你! 未来机器人网站优化公司旨在帮助更多的企业网站做好搜索引擎优化,提升自然快照排名,帮您低成本获客。-

整站SEO优化

3元/天/词

1、百度、搜狗和360搜索引擎

2、按效果付费、不花冤枉钱

3、进首页词量多、转化效果好

4、量化交付、专业团队执行 -

指定关键词优化

5元/天/词

1、科学、稳定、持续、可控

2、指定关键词按天计费

3、不在首页不扣费

4、不限指数 -

AI智能营销

1元/天

1、AI智能化营销、智能化运营

2、接口灵活对接网站和自媒体

3、一个人顶一个团队

4、AIGC内容管理平台